Основные факторы влияющие на производительность пк. Влияние параметров памяти на производительность системы

* всегда актуальные вопросы, на что стоит обращать внимание при выборе процессора, чтобы не ошибиться.

Наша цель в данной статье — описать все факторы влияющие на производительность процессора и другие эксплуатационные характеристики.

Наверняка ни для кого не секрет, что процессор – является главной вычислительной единицей компьютера. Можно даже сказать – самая главная часть компьютера.

Именно он занимается обработкой практически всех процессов и задач, которые происходят в компьютере.

Будь то — просмотр видео, музыка, интернет сёрфинг, запись и чтение в памяти, обработка 3D и видео, игр. И многого другого.

Поэтому к выбору Ц ентрального П роцессора, стоит отнестись очень тщательно. Может получиться ситуация, что вы решили поставить мощную видеокарту и не соответствующий её уровню процессор. В этом случае процессор, не будет раскрывать потенциал видеокарты, что будет тормозить её работу. Процессор будет полностью загружен и буквально кипеть, а видеокарта будет ожидать своей очереди, работая на 60-70% от своих возможностей.

Именно поэтому, при выборе сбалансированного компьютера, не стоит пренебрегать процессором в пользу мощной видеокарты. Мощности процессора должно быть достаточно для раскрытия потенциала видеокарты, иначе это просто выброшенные деньги.

Intel vs. AMD

*догонялки навсегда

Корпорация Intel , располагает огромными человеческими ресурсами, и почти неисчерпаемыми финансами. Многие инновации в полупроводниковой индустрии и новые технологии идут именно из этой компании. Процессоры и разработки Intel , в среднем на 1-1,5 года опережают наработки инженеров AMD . Но как известно, за возможность обладать самыми современными технологиями – приходится платить.

Ценовая политика процессоров Intel , основывается как на количестве ядер , количестве кэша , но и на «свежести» архитектуры , производительности на такт ватт , техпроцесса чипа . Значение кэш-памяти, «тонкости техпроцесса» и другие важные характеристики процессора рассмотрим ниже. За обладание такими технологии как и свободного множителя частоты, тоже придётся выложить дополнительную сумму.

Компания AMD , в отличии от компании Intel , стремится к доступности своих процессоров для конечного потребителя и к грамотной ценовой политике.

Можно даже сказать, что AMD – «Народная марка ». В её ценниках вы найдёте то, что вам нужно по очень привлекательной цене. Обычно через год, после появления новой технологии у компании Intel , появляется аналог технологии от AMD . Если вы не гонитесь за самой высокой производительностью и больше обращаете внимание на ценник, чем на наличие передовых технологий, то продукция компании AMD – именно для вас.

Ценовая политика AMD , больше основывается на количестве ядер и совсем немного — на количестве кэш памяти, наличии архитектурных улучшений. В некоторых случаях, за возможность обладать кэш памятью третьего уровня, придётся немного доплатить (Phenom имеет кэш память 3 уровня, Athlon довольствуется только ограниченной, 2 уровня). Но иногда AMD «балует» своих фанатов возможность разблокировать более дешёвые процессоры, до более дорогих. Разблокировать можно ядра или кэш-память. Улучшить Athlon до Phenom . Такое возможно благодаря модульной архитектуре и при недостатке некоторых более дешёвых моделей, AMD просто отключает некоторые блоки на кристалле более дорогих (программно).

Ядра – остаются практически неизменными, отличается только их количество (справедливо для процессоров 2006-2011 годов). За счёт модульности своих процессоров, компания отлично справляется со сбытом отбракованных чипов, которые при отключении некоторых блоков, становятся процессором из менее производительной линейки.

Компания много лет работала над совершенно новой архитектурой под кодовым именем Bulldozer , но на момент выхода в 2011 году, новые процессоры показали не самую лучшую производительность. AMD грешила на операционные системы, что они не понимают архитектурных особенностей сдвоенных ядер и «другой многопоточности».

Со слов представителей компании, следует ждать особых исправлений и заплаток, чтобы ощутить всю производительность данных процессоров. Однако в начале 2012 года, представители компании отложили выход обновления для поддержки архитектуры Bulldozer на вторую половину года.

Частота процессора, количество ядер, многопоточность.

Во времена Pentium 4 и до него – частота процессора , была главным фактором производительности процессора при выборе процессора.

Это не удивительно, ведь архитектуры процессоров — специально разрабатывались для достижения высокой частоты, особенно сильно это отразилось как раз в процессоре Pentium 4 на архитектуре NetBurst . Высокая частота, была не эффективна при том длинном конвейере, что был использован в архитектуре. Даже Athlon XP частотой 2Ггц , по уровню производительности был выше чем Pentium 4 c 2,4Ггц . Так что, это был чистой воды маркетинг. После этой ошибки, компания Intel осознала свои ошибки и вернулась на сторону добра начала работать не над частотной составляющей, а над производительностью на такт. От архитектуры NetBurst пришлось отказаться.

Что же нам даёт многоядерность ?

Четырёх-ядерный процессор с частотой 2,4 Ггц , в много-поточных приложениях, теоретически будет примерным эквивалентом, одноядерного процессора с частотой 9,6Ггц или 2-х ядерному процессору с частотой 4,8 Ггц . Но это только теоретически . Практически же, два двухъядерных процессора в двух сокетной материнской плате, будут быстрее одного 4-ядерного, на той же частоте функционирования. Ограничения по скорости шины и задержки памяти дают о себе знать.

* при условии одинаковых архитектур и количества кэш памяти

Многоядерность, даёт возможность выполнять инструкции и вычисления по частям. К примеру нужно выполнить три арифметических действия. Первые два выполняются на каждом из ядер процессора и результаты складываются в кэш-память, где с ними может быть выполнено следующее действие любым из свободных ядер. Система очень гибкая, но без должной оптимизации может и не работать. Потому очень важна оптимизация под многоядерность для архитектуры процессоров в среде ОС.

Приложения, которые «любят» и используют многопоточность: архиваторы , плееры и кодировщики видео , антивирусы , программы дефрагментаторы , графические редакторы , браузеры , Flash .

Так же, к «любителям» многопоточности, можно отнести такие операционные системы как Windows 7 и Windows Vista , а так же многие ОС , основанные на ядре Linux , которые работают заметно быстрее при наличии многоядерного процессора.

Большинству игр , бывает вполне достаточно 2-х ядерного процессора на высокой частоте. Сейчас однако, выходит всё больше игр «заточенных» под многопоточность. Взять хотя бы такие SandBox игры, как GTA 4 или Prototype , в которые на 2-х ядерном процессоре с частотой ниже 2,6 Ггц – комфортно себя не чувствуешь, фреймрейт проваливается ниже 30 кадров в секунду. Хотя в данном случае, скорее всего причиной таких казусов является «слабая» оптимизация игр, недостаток времени или «не прямые» руки тех, кто переносил игры с консолей на PC .

При покупке нового процессора для игр, сейчас стоит обращать внимание на процессоры с 4-мя и более ядрами. Но всё же, не стоит пренебрегать 2-х ядерными процессорами из «верхней категории». В некоторых играх, данные процессоры чувствуют себя порой лучше, чем некоторые многоядерные.

Кэш память процессора.

– это выделенная область кристалла процессора, в которой обрабатываются и хранятся промежуточные данные между процессорными ядрами, оперативной памятью и другими шинами.

Она работает на очень высокой тактовой частоте (обычно на частоте самого процессора), имеет очень высокую пропускную способность и процессорные ядра работают с ней напрямую (L1 ).

Из-за её нехватки , процессор может простаивать в трудоёмких задачах, ожидая пока в кэш поступят новые данные для обработки. Так же кэш-память служит для записи часто повторяющихся данных, которые при необходимости могут быть быстро восстановлены без лишних вычислений, не заставляя процессор тратить время на них снова.

Производительности, так же добавляет факт, если кэш память объединённая, и все ядра равноправно могут использовать данные из неё. Это даёт дополнительные возможности для многопоточной оптимизации.

Такой приём, сейчас используется для кэш памяти 3-го уровня . У процессоров Intel существовали процессоры с объединённой кэш памятью 2-го уровня (C2D E 7*** , E 8*** ), благодаря которым и появился данный способ увеличить многопоточную производительность.

При разгоне процессора, кэш память может стать слабым местом, не давая разогнать процессор больше, чем её предельная частота функционирования без ошибок. Однако плюсом является то, что она будет работать на той же частоте, что и разогнанный процессор.

В общем, чем больше кэш памяти, тем быстрее процессор. В каких именно приложениях?

Во всех приложениях, где используется множество числовых данных с плавающей запятой, инструкций и потоков, кэш память активно используется. Кэш память очень любят архиваторы , кодировщики видео , антивирусы и графические редакторы и т.д.

Благоприятно к большому количеству кэш-памяти относятся игры . Особенно стратегии, авто-симуляторы, RPG, SandBox и все игры, где есть много мелких деталей, частиц, элементов геометрии, потоков информации и физических эффектов.

Кэш память играет очень немалую роль в раскрытии потенциала систем с 2-мя и более видеокартами. Ведь какая то доля нагрузки, ложится на взаимодействие ядер процессора как между собой, так и для работы с потоками нескольких видео-чипов. Именно в этом случае важна организация кэш — памяти, и очень полезна кэш память 3-го уровня большого объёма.

Кэш память, всегда оснащается защитой от возможных ошибок (ECC ), при обнаружении которых, ведётся их исправление. Это очень важно, ведь маленькая ошибочка в кэш памяти, при обработке может превратиться в гигантскую, сплошную ошибку, от которой «ляжет» вся система.

Фирменные технологии.

(гипер-поточность, HT )–

впервые технология была применена в процессорах Pentium 4 , но работала не всегда корректно и зачастую больше тормозила процессор, чем ускоряла. Причиной был слишком длинный конвейер и не доведённая до ума система предсказания ветвлений. Применяется компанией Intel , аналогов технологии пока нет, если не считать аналогом то? что реализовали инженеры компании AMD в архитектуре Bulldozer .

Принцип системы таков, что на каждое физическое ядро, создаётся по два вычислительных потока , вместо одного. То есть, если у вас 4-х ядерный процессор с HT (Core i 7 ), то виртуальных потоков у вас 8 .

Прирост производительности достигается за счёт того, что в конвейер могут поступать данные уже в его середине, а не обязательно сначала. Если какие то блоки процессора, способные выполнить это действие простаивают, они получают задачу к выполнению. Прирост производительности не такой как у настоящих физических ядер, но сопоставимый(~50-75%, в зависимости от рода приложения). Довольно редко бывает, что в некоторых приложениях, HT отрицательно влияет на производительность. Связано это с плохой оптимизацией приложений под данную технологию, невозможность понять, что присутствуют потоки «виртуальные» и отсутствие ограничителей для нагрузки потоков равномерно.

Turbo Boost – очень полезная технология, которая увеличивает частоту функционирования наиболее используемых ядер процессора, в зависимости от уровня их загруженности. Очень полезна тогда, когда приложение не умеет использовать все 4 ядра, и загружает только одно или два, при этом их частота работы повышается, что частично компенсирует производительность. Аналогом данной технологии у компании AMD , является технология Turbo Core .

, 3 dnow ! инструкции . Предназначены для ускорения работы процессора в мультимедиа вычислениях (видео, музыка, 2D/3D графика и т.д.), а так же ускоряют работу таких программ как архиваторы, программы для работы с изображениями и видео (при поддержке инструкций данными программами).

3dnow ! – довольно старая технология AMD , которая содержит дополнительные инструкции по обработке мультимедиа контента, помимо SSE первой версии .

*А именно возможность потоковой обработки вещественных чисел одинарной точности.

Наличие самой новой версии – является большим плюсом, процессор начинает более эффективно выполнять определённые задачи при должной оптимизации ПО. Процессоры AMD носят похожие названия, но немного другие.

* Пример — SSE 4.1(Intel) — SSE 4A(AMD).

К тому же, данные наборы инструкций не идентичны. Это аналоги, в которых есть небольшие отличия.

Cool’n’Quiet, SpeedStep, CoolCore, Enchanced Half State(C1E) и т . д .

Данные технологии, при низкой нагрузке уменьшают частоту процессора, посредством уменьшения множителя и напряжения на ядре, отключения части КЭШа и т.д. Это позволяет процессору гораздо меньше греться и потреблять меньше энергии, меньше шуметь. Если понадобится мощность, то процессор вернётся в обычное состояние за доли секунды. На стандартных настройках Bios практически всегда включены, при желании их можно отключить, для уменьшения возможных «фризов» при переключении в 3D играх.

Некоторые из этих технологий, управляют скоростью вращения вентиляторов в системе. К примеру, если процессор не нуждается в усиленном отводе тепла и не нагружен, скорость вентилятора процессора уменьшается (AMD Cool’n’Quiet, Intel Speed Step ).

Intel Virtualization Technology и AMD Virtualization .

Эти аппаратные технологии позволяют с помощью специальных программ запускать несколько операционных систем сразу, без какой либо сильной потери в производительности. Так же, её используют для правильной работы серверов, ведь зачастую, на них установлена далеко не одна ОС.

Execute Disable Bit и No eXecute Bit – технология, призванная защитить компьютер от вирусных атак и программных ошибок, которые могут вызвать крах системы посредством переполнения буфера .

Intel 64 , AMD 64 , EM 64 T – данная технология позволяет процессору работать как в ОС с 32-х битной архитектурой, так и в ОС с 64-х битной. Система 64 bit – с точки зрения выгоды, для рядового пользователя отличается тем, что в данной системе можно использовать более 3.25Гб оперативной памяти. В 32-х битных системах, использовать бо льший объём оперативной памяти не представляется возможным, из-за ограниченного объёма адресуемой памяти* .

Большинство приложений с 32-х bit архитектурой, можно запустить на системе с 64-х битной ОС.

* Что же поделать, если в далёком 1985 году, никто и подумать не мог о таких гигантских, по меркам того времени, объёмах оперативной памяти.

Дополнительно.

Пара слов о .

На этот пункт стоит обратить пристальное внимание. Чем тоньше техпроцесс, тем меньше процессор потребляет энергии и как следствие — меньше греется. И кроме всего прочего — имеет более высокий запас прочности для разгона.

Чем более тонкий техпроцесс, тем больше можно «завернуть» в чип (и не только) и увеличить возможности процессора. Тепловыделение и энергопотребление при этом тоже уменьшается пропорционально, благодаря меньшим потерям по току и уменьшению площади ядра. Можно заметить тенденцию, что с каждым новым поколением той же архитектуры на новом техпроцессе, растёт и энергопотребление, но это не так. Просто производители идут в сторону ещё большей производительности и перешагивают за черту тепловыделения прошлого поколения процессоров из-за увеличения числа транзисторов, которое не пропорционально уменьшению техпроцесса.

Встроенное в процессор .

Если вам не нужно встроенное видео ядро, то не стоит покупать процессор с ним. Вы получите только худший отвод тепла, лишний нагрев (не всегда), худший разгонный потенциал (не всегда), и переплаченные деньги.

К тому же те ядра, что встроены в процессор, годятся только для загрузки ОС, интернет сёрфинга и просмотра видео (и то не любого качества).

Тенденции на рынке все же меняются и возможность купить производительный процессор от Intel без видео ядра выпадает всё реже. Политика принудительного навязывание встроенного видео ядра, появилась с процессоров Intel под кодовым названием Sandy Bridge , основное новшество которых и было встроенное ядро на том же техпроцессе. Видео-ядро, находится совместно с процессором на одном кристалле , и не такое простое как в предыдущих поколениях процессоров Intel . Для тех кто его не использует, есть минусы в виде некоторой переплаты за процессор, смещённость источника нагрева относительно центра тепло — распределительной крышки. Однако есть и плюсы. Отключенное видео ядро, можно использовать для очень быстрой кодировки видео с помощью технологии Quick Sync вкупе со специальным, поддерживающим данную технологию ПО. В будущем, Intel обещает расширить горизонты использования встроенного видео ядра для параллельных вычислений.

Сокеты для процессоров. Сроки жизни платформ .

Intel ведёт грубую политику для своих платформ. Срок жизни каждой (срок начала и конца продаж процессоров для неё), обычно не превышает 1.5 — 2 года. К тому же, у компании есть несколько параллельно развивающихся платформ.

Компания AMD , ведёт противоположную политику совместимости. На её платформу на AM 3 , будут подходить все процессоры будущих поколений, поддерживающие DDR3 . Даже при выходе платформы на AM 3+ и более поздних, отдельно будут выпускаться либо новые процессоры под AM 3 , либо новые процессоры будут совместимы со старыми материнскими платами, и можно будет сделать безболезненный для кошелька апгрейд, поменяв только процессор (без смены мат.платы, ОЗУ и т.д.) и прошив материнской платы. Единственные нюансы несовместимости могут быть при смене типа , так как будет требоваться другой контроллёр памяти, встроенный в процессор. Так что совместимость ограниченная и поддерживается далеко не всеми материнскими платами. Но в целом, экономному пользователю или тем, кто не привык менять платформу полностью каждые 2 года — выбор производителя процессора понятен — это AMD .

Охлаждение процессора.

В стандартной комплектации, с процессором идёт BOX -овый кулер, который будет просто справляться со своей задачей. Представляет он из себя кусок алюминия с не очень высокой площадью рассеивания. Эффективные кулеры на тепловых трубках и закреплёнными на них пластинами, имеют конструкцию, предназначенную для высокоэффективного рассеивания тепла. Если вы не хотите слышать лишний шум от работы вентилятора, то вам стоит приобрести альтернативный, более эффективный кулер с тепловыми трубками, либо систему жидкостного охлаждения замкнутого или не замкнутого типа. Такие системы охлаждения, дополнительно дадут возможность разгона для процессора.

Заключение.

Все важные аспекты, влияющие на производительность и эксплуатационные характеристики процессора, были рассмотрены. Повторим, на что следует обращать внимание:

- Выбрать производителя

- Архитектура процессора

- Техпроцесс

- Частота процессора

- Количество ядер процессора

- Размер и тип кэш-памяти процессора

- Поддержка технологий и инструкций

- Качественное охлаждение

Надеемся, данный материал поможет вам разобраться и определиться в выборе соответствующего вашим ожиданиям процессора.

1) Удаление лишних программ из автозагрузки

В процессе загрузки компьютера происходит автоматическая загрузка и запуск всех установленных программ, находящихся в разделе автозагрузки в системе. Они Вам не мешают в большей степени, но «пожирают» некоторую часть ресурсов оперативной памяти ПК, что способствует замедлению работы системы. Чтобы убрать лишние программы из автозагрузки нужно зайти в Конфигурацию системы (Msconfig):

Но в реальности есть легкие изменения, которые вы можете сделать, чтобы ускорить работу вашего компьютера. Если в течение всего времени, которое требуется компьютеру для загрузки, весь варочный раствор кофе может завариться, пришло время внести некоторые изменения. Скорее всего, ваш компьютер не медленный - это десятки программ, включенных во время запуска, которые замедляют работу.

Если вы не распознаете программу, оставьте ее. Перезагрузите компьютер и посмотрите, как он летает. Если болезненным медленным серфингом является ваша главная проблема, есть несколько быстрых изменений, которые вы можете сделать. Это связано не только с удалением программ, которые вы больше не используете.

Пуск

– Панель управления

– Система и безопасность

– Администрирование

– Конфигурация системы

или

Пуск

- Выполнить

- набираем msconfig

или

комбинация клавиш Win+R

- набираем msconfig

В этой вкладке расположен полный список загружаемых программ, которые запускаются при запуске Windows 7. Отключаем те программы которые используются крайне редко, либо не используются совсем. Тут можно отключить программу, которая, например, при загрузке системы выдавала какую то ошибку. Из данного списка не рекомендуется отключать автозапуск Вашего антивируса, т.к при следующей перезагрузке он может просто не запуститься.

Так же отключить Авотозапуск можно через:

Пуск

- Выполнить

- набираем regedit

или

комбинация клавиш Win+R

- набираем regedit

Убедитесь, что для этого установлено значение «Автоматическая загрузка и установка». Быстрая и бесплатная программа сканирует ваш компьютер и возвращает отчеты с любыми доступными обновлениями за считанные секунды. Поэтому важно уделять пристальное внимание лицензионным соглашениям и экранам установки при установке чего-либо из Интернета. Если на экране установки вы выбрали пользовательские или расширенные параметры установки, рекомендуется выбрать их, поскольку они, как правило, будут раскрывать, как будет установлено другое программное обеспечение сторонних разработчиков.

Автозапуск расположен в следующих ветках реестра:

HKEY_LOCAL_MACHINE\SOFTWARE\Microsoft\Windows\CurrentVersion\Run

HKEY_CURRENT_USER\Software\Microsoft\Windows\CurrentVersion\Run

Внимание ! Если Вы не знаете что такое реестр и не умеете им пользоваться, то лучше туда не лезть!

Отключение не нужных или редко используемых служб, позволит немного разгрузить оперативную память, что предоставит возможность другим приложениям работать быстрее. Перед тем, как отключать какие либо службы, рекомендуется создать точку восстановления системы

на случай осложнений (особенно для не опытных пользователей):

Панель управления

-> Система

-> Защита системы

-> Создать…

После создания точки восстановления, заходим в компонент Службы , который находится по пути:

Пуск

– Панель управления

– Администрирование

– Службы

.

Находим в списке нужную службу , кликаем по ней 2 раза левой кнопкой мышки. Если она запущена жмем в кнопку Остановить , а затем выбираем Тип запуска – Отключена .

Вот список служб, в большинстве случаев не используемых в домашних условиях:

Windows CardSpace

Windows Search

Автономные файлы

Агент защиты сетевого доступа

Адаптивная регулировка яркости

Архивация Windows

Вспомогательная служба IP

Вторичный вход в систему

Группировка сетевых участников

Дефрагментация диска

Диспетчер автоматический подключений удаленного доступа

Диспетчер печати (если нет принтеров)

Диспетчер подключений удаленного доступа (если нет VPN)

Диспетчер удостоверения сетевых участников

Журналы и оповещения производительности

Защитник Windows (?)

Защищенное хранилище

Настройка сервера удаленных рабочих столов

Политика удаления смарт-карт

Прослушиватель домашней группы

Сборщик событий Windows

Сетевой вход в систему

Служба ввода планшетного ПК

Служба загрузки изображений Windows (WIA) (если нет сканера или фотика)

Служба планировщика Windows Media Center

Смарт-карта

Узел системы диагностики

Узел службы диагностики

Факс

Хост библиотеки счетчика производительности

Центр обеспечения безопасности

Центр обновления Windows

Это руководство по удалению может оказаться подавляющим из-за количества шагов и многочисленных программ, которые будут использоваться. Это было написано только таким образом, чтобы предоставить четкие, подробные и легко понятные инструкции, которые любой может использовать для удаления этой инфекции бесплатно. Перед использованием этого руководства мы рекомендуем вам прочитать его один раз и загрузить все необходимые инструменты на рабочий стол. После этого распечатайте эту страницу, так как вам может потребоваться закрыть окно браузера или перезагрузить компьютер.

По желанию можно отключить все визуальные эффекты, но рекомендуется оставить пункт Использование стилей отображения для окон и кнопок

, чтобы системы смотрелась не совсем упрощенной.

Заходим в настройки:

Пуск – Панель управления – Система

Во вкладке Дополнительно

в пункте Быстродействие

щелкаем Параметры

.

Если какая-либо из программ попросит вас перезагрузить компьютер, не разрешайте перезагрузке до тех пор, пока вы не удалите все перечисленные выше программы. Когда вы закончите, вы можете закрыть экраны панели управления. Когда вам будет предложено сохранить его, сохраните его на рабочем столе.

Будьте терпеливы, пока программа ищет различные вредоносные программы и заканчивает их. По завершении черное окно автоматически закроется и откроется файл журнала. Просмотрите файл журнала и закройте его, чтобы продолжить выполнение следующего шага. Обратите внимание, что страница загрузки откроется в новом окне браузера или вкладке.

Банально с одной стороны, но всё же имеет место если Ваша система Windows не защищена антивирусом, то глюки и тормоза могут возникнуть из за проникновения в компьютер вируса. Для решения этой проблемы нужно скачать и установить любой антивирус, обновить его вирусные базы и полностью просканировать систему.

5) Очистка реестра и временных файлов системы для увеличения скорости работы Windows 7

Загрузка довольно большая, поэтому, пожалуйста, будьте терпеливы, пока она загружается. Теперь вы должны увидеть диалоговое окно с просьбой согласиться с лицензионным соглашением. Если у вас по-прежнему возникают проблемы с компьютером после выполнения этих инструкций, выполните следующие действия, описанные ниже.

Если вы хотите полностью защищаться в любое время, рекомендуется приобрести премиум-версию. Отказ от ответственности: хотя мы действительно получаем комиссию от продажи вышеуказанных продуктов, будьте уверены, мы рекомендуем их только по их эффективности.

Системный Реестр представляет собой особую директорию системы Windows, представленную в виде Базы Данных, в которой хранятся следующие сведения:

Все установки и опции операционной системы

Все установленные устройства компьютера

Различные учетные записи пользователя

Набор инсталлированных приложений

Так вот со времен эта «база данных» собирает в себе ненужную, старую и не актуальную информацию о любых Ваших действиях в системе. Даже после удаления определенных программ и утилит в реестре может оставаться информация о данном софте. Впоследствии вся эта информация может негативно влиять на работоспособность компьютера, в частности на скорость работы. Наиболее простой способ очистить реестр от мусора - это установка программы для чистки реестра и временных файлов. Я рекомендую Вам Ccleaner, она бесплатная русскоязычная и отлично справляется со своими задачами.

Что делать, чтобы ускорить работу Windows

Если у вас есть какие-либо вопросы об этом руководстве по самопомощи, пожалуйста, напишите эти вопросы в нашей и кто-то вам поможет. Некоторые недостатки можно смягчить благодаря творческой реализации и тщательной индексации, но они все еще присутствуют.

Уникальные программные реализации

Это приводит к меньшему износу хост-приводов и отключению, занимая гораздо меньше времени. Они больше привлекают пользователей, которые хотят их использовать для конкретных целей. Это гарантирует отсутствие потери данных в случае повышения мощности. Для серверов может быть полезно, но для большинства пользователей это не будет и может быть проигнорировано.

Вдобавок после очистки у Вас удалится куча ненужного хлама и мусора, которое освободит драгоценное место на жестком диске. Скачать программу можно с.

6) Отключение Контроля учетных записей UAC (User Account Control)

Контроль учетных записей (UAC) извещает пользователя о тех или иных изменениях в системе, которые требуют прав администратора. Эта служба выводит уведомления при попытке установить новую программу, при внесении изменений в файловую систему и т.д. Это может быть полезно новичкам, но опытным пользователям зачастую мешает. Чтобы отключить вывод уведомлений от User Account Control нужно проделать следующее:

Самый быстрый инструмент оптимизации системы в мире

Ваш конечный компьютер

Мощная утилита мониторинга системы и аппаратного обеспечения.- Запретить изменения в браузере по умолчанию.

- Со временем жесткий диск вашего компьютера и реестр будут загромождены.

- Вы будете поражены его пылающей скоростью дефрагментации.

- При запуске компьютера многие программы запускаются тихо в фоновом режиме.

Запустить Конфигурацию системы

(msconfig

в командной строке (Пуск - выполнить))

Перейти на вкладку Сервис

и в списке найти пункт Настройка контроля учетных записей

Выделить этот пункт и нажать кнопку Запустить

.

Откроется диалог, в котором ползунком нужно отрегулировать выдачу уведомлений.

Факторы, влияющие на производительность

Одна из проблем с этим программным обеспечением заключается в том, что они отчаянно пытаются найти что-то «неправильное» в вашей системе. Если они не могут идентифицировать неисправности в вашей системе, они не полезны. Поэтому они стимулируют преувеличение любой потенциальной проблемы и создают большой театр о том, как ваша система работает плохо или заполнена «мусорными» файлами.

Внесенные изменения активируются после перезагрузки компьютера.

И еще один важный момент. Если Вы все таки не выключили UAC, то крайне важно при запросе повышения прав смотреть, какая программа запрашивает их. Ни в коем случае не спешите нажимать кнопку «Да». Особенно если Вы сейчас ничего не запускали, а появился запрос. А в отношении других программ - постарайтесь брать их из доверенных источников, чтобы самим не дать разрешение за запуск вредоносного программного обеспечения.

7) Настройка приоритета процессов

Для того, чтобы запущенные приложения работали быстрее, нужно задать им более высокий приоритет по сравнению с фоновыми процессами. В этом случае активным приложениям будет выделяться больше процессорного времени. По умолчании система так и настроена, но баланс между ресурсами для активный, и для фоновых процессов можно сдвинуть еще больше.

За это отвечает значение Win32PrioritySeparation

, которое лежит в ветке реестра HKEY_LOCAL_MACHINE\System\CurrentControlSet\Control\PriorityControl

.

Настройка визуальных эффектов

По умолчанию он будет дублировать значок аккумулятора системы. Диспетчер аккумуляторов позволяет выбирать между двумя режимами питания и тремя планами питания. В нормальном режиме батарея заряжается на 100% и полностью заряжает аккумулятор. Режим сохранения - лучший вариант, если вы обычно оставляете ноутбук включенным в зарядное устройство в любое время. Вы можете изменить его в нормальный режим за час до того, как собираетесь отключить ноутбук, но для этого требуется некоторое планирование по сравнению с тем, чтобы он всегда оставался в нормальном режиме.

Для открытия системного реестра – наберите «regedit» в командной строке.

По умолчанию стоит шестнадцатеричное значение – 2

(hex)

Рекомендуемое значение – 6

(hex)

Диапазон допустимых значений: от 1

до 26

(hex)

Вы можете попробовать другие значения, чтобы максимально ускорить работу Вашей системы.

Внимание : использовать значение 0 нельзя, ваш компьютер сразу же зависнет!

Этот процесс включает полную зарядку аккумулятора, его полное истощение, а затем полностью перезарядить его. Процесс занимает несколько часов, поэтому ноутбук должен быть подключен в любое время и не должен прерываться. Это рекомендуемая процедура для всех литиевых базовых батарей, хотя есть большие разногласия относительно того, как часто это должно выполняться.

Помнить, что делать это без подсказок уведомления может быть более сложной задачей. На той же вкладке вы также можете перевести батарею в спящий режим, если компьютер не должен использоваться в течение нескольких месяцев. Программное обеспечение, предназначенное для принятия решений о том, когда и что «чистить» оставляет желать лучшего. Разрешить запуск одной из этих программ в вашей системе - это как очистить вашу квартиру, выложив все свои вещи перед тем, как разрастается носорог. Он не принимает во внимание, показывают ли ваши шаблоны использования, что вы фактически используете какие-либо данные, которые он слишком хочет удалить.

Кроме изменения общего баланса ресурсов процессора, можно устанавливать более высокий приоритет отдельным программам. Сделать это можно через Диспетчер задач.

8) Произвести апгрейт компьютера

Почему вы хотите, чтобы было труднее найти путь назад к документам и веб-сайтам, которые вы открыли ранее? Очистка моих журналов не очистка, это уничтожение ценных пользовательских данных. Резервный системный реестр Неверные элементы реестра Оставшаяся информация о программном обеспечении. Эти рекомендации опасны. Внедрение изменений во всем системном реестре и слепое удаление явно неиспользуемых или непривязанных ключей - это рецепт катастрофы. Если вам не нравится создавать и использовать точки восстановления системы, вам не следует возиться с этим.

В настоящее время большое распространение получили твердотельные SSD накопители, ведь при установке их в Ваш компьютер, он действительно начинает работает быстрее и дает заметный любому глазу эффект. В некоторых тестах проводимых в сравнении с обычными жесткими дисками, достигалось трехкратное увеличение скорости считывания и обработки данных на компьютере. Так что после установки SSD накопителя на Ваш компьютер или ноутбук, Вы сможете ускорить загрузку Windows в разы, плюс намного быстрее будут работать все приложения установленные в вашей системе.

Кроме замены жеского диска, можно увеличить оперативной память компьютера. Установка дополнительной оперативной памяти всегда существенно повышает производительность и ускоряет работу компьютера. Для 32-битной Windows 7 будет оптимальным 3 ГБ оперативной памяти. Для быстрой работы 64-битной Windows 7 нужно не менее 4 ГБ ОЗУ. Если вы часто редактируете видео или пользуетесь другими, жадными до памяти программами, то для повышения производительности вам потребуется еще больше оперативной памяти.

Это может привести к повреждению вашей системы или программного обеспечения, запускаемого на нем. Это ключи, которые активно использовались установленным программным обеспечением и которые не должны были удаляться. Более компетентные редакторы реестра представят списки ключей, которые, по его мнению, могут быть полезны для удаления вместе с данными, используемыми для определения того, должен ли элемент быть удален или нет. Автоматическое программное обеспечение просто не может принять это решение самостоятельно.

Удаление многих из этих элементов может замедлить работу вашего компьютера при выполнении повседневных задач. Очистка корзины - это единственное, что не будет иметь негативных последствий. Временные интернет-файлы - это такие вещи, как логотипы и другие часто используемые файлы с ваших любимых веб-сайтов. Если у них нет копий, хранящихся на вашем компьютере, вы должны загрузить их снова с серверов веб-сайта, что будет медленнее, чем просто копирование на вашем локальном компьютере.

9) Отключение неиспользуемых компонентов Windows 7

Как известно, при запуске Windows загружает много служб и компонентов, что не совсем хорошо сказывается на производительности системы. Службы которые мы не используем уже выключили в пункте Отключение лишних и ненужных служб и компонентов для ускорения системы Windows 7 . Теперь нам необходимо избавиться от не нужных компонентов, тем самым освободив часть оперативной памяти. Для этого переходим:

Удаление всего в папке «Загрузки» за один раз без предварительного просмотра того, что внутри, сначала звучит как плохая идея. Вы действительно сделали копию этой квитанции? Вы переместили эти песни в папку «Музыка» или нет? Является ли ваша единственная копия этого контракта в папке «Загрузки»? Как с бесцеремонным объявлением файлов журнала вашего компьютера «мусор»; удаляя всю папку «Загрузки» за один раз, не проверяя, что содержимое слишком опасно для моего вкуса. Некоторые пользователи, вероятно, никогда не дают файлам второй взгляд и будут рады, если бы они «очистились» для них.

Пуск - Панель Управления - Программы и компоненты

Выбираем пункт. Нажимаем на кнопку Включение или отключение компонентов Windows

в левой панели.

По умолчанию некоторые компоненты уже отключены, так что нам остается отключить только те, которые нам не нужны:

Internet Explorer (Для тех, кто использует альтернативные браузеры)

Telnet-сервер

Windows Search (если Вы не используете поиск в Windows)

Клиент Telnet

Клиент TFTP

Компоненты планшетного ПК

Платформа гаджетов Windows (Если не хотите загружать рабочий стол гаджетами)

Подсистема Unix-приложений

Сервер очереди сообщений Майкрософт

Служба активации Windows

Служба индексирования

Службы печати и документов (Если принтер не подключен)

После того как сняты галки остается перезагрузить компьютер

10) Использование ReadyBoost

Windows ReadyBoost – это технология поддержки повышения производительности операционной системы. Ускорение работы системы Windows 7 осуществляется за счет использования свободного места (кеширования) на подключаемом к ПК или ноутбуку (как правило, через порт USB) съемном устройстве (флешь карта, карта памяти, переносной съемный диск).

Включить эту технологию можно следующим образом: при подключении съемного носителя, будь то флешь или жесткий диск, появляется окно Автозапуск

, с различными вариантами действий. Нам нужно выбрать пункт Ускорить работу системы

, используя Windows ReadyBoost;

– в окне Свойства : Съемный диск откройте вкладку ReadyBoost ;

– система определит, сколько места можно зарезервировать на этом устройстве (если свободного места меньше, чем требуется системе, задействовать ReadyBoost не удастся, пока вы не освободите место);

Самая популярная проблема, с которой сталкивается, наверное, каждый пользователь - это медленная работа персонального компьютера. По разным причинам со временем система отказывается работать правильно и быстро. Но существует несколько способов решения этой проблемы как на аппаратном. так и на программном уровне. Эти способы предлагаю рассмотреть ниже.

Факторы, влияющие на производительность

Производительность - это скорость обрабатываемой компьютером информации за определённую единицу времени. И чем эта скорость больше, тем соответственно выше производительность.

Одним из самых важных критериев работы ПК является производительность

Одним из самых важных критериев работы ПК является производительность

Основные признаки медленной работы компьютера

Основными признаками компьютера являются: долгое время включения и выключения компьютера, подозрительно долгий запуск программ и приложений, запоздалая реакция на передвижение курсора и нажатие, а также другие признаки.

Что влияет на производительность компьютера

На производительность компьютера влияют следующие факторы:

- несовместимость программного обеспечения компьютера, программ, игр, операционной системы с комплектующими ПК;

- присутствие посторонних, ненужных файлов;

- поломка кулера или же плохой отвод тепла от центральных частей компьютера;

- во многих случаях причиной является конфликт между программами: установка двух антивирусов одновременно или несовместимых драйверов это подтверждает.

- ошибки в настройке операционной системы и/или неправильное её использование;

- нарушение работы BIOS;

- заражение вредоносными программами;

Аппаратное ускорение компьютера

Виной медленной работы компьютера может быть неактивное аппаратное ускорение

Виной медленной работы компьютера может быть неактивное аппаратное ускорение

При затруднении работы видеокарты компьютера (неправильном изображении, запаздывании, самопроизвольном отключении визуальных эффектов) следует использовать аппаратное ускорение компьютера.

В широком смысле - это разгрузка центрального процессора с применением аппаратных средств раздельного выполнения задач, т.е. распределение работы по нескольким аппаратным модулям. К примеру, обработка видео -файлов различных форматов занимает большую часть оперативной памяти компьютера, и чтобы разгрузить центральный процессор, используется аппаратный модуль-ускоритель.

Корректная работа аппаратных ускорителей заключается в установке необходимых драйверов на компьютер. В общем, вся работа аппаратных ускорителей строится на поддержке программного обеспечения и целой базы драйверов в операционной системе. Графический интерфейс, визуальные эффекты требуют аппаратного ускорения работы, как и многие графические движки современных игр и видеоредакторов.

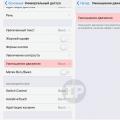

Как включается аппаратное ускорение

На операционной системе windows 7 аппаратное ускорение включается так:

- устанавливается специальный драйвер (в большинстве случаев);

- щелчок правой кнопкой мыши на Рабочем столе -> «Персонализация» -> в графе «Экран» выбираем настройки параметров, дополнительные параметры. Далее изменяем параметры во вкладке «Диагностика». В этой вкладке будет находиться регулировка режима аппаратного ускорения:

- Настройка видеокарт отдельных фирм в специализированных программах (в разделе аппаратного ускорения и преобразования видео):

За настройками аппаратного ускорения чаще всего следит драйвер

За настройками аппаратного ускорения чаще всего следит драйвер

Отключить ускорение можно, проделав инструкицию, указанную выше, но передвинув ползунок в другую сторону. Зачастую функция аппаратного ускорения недоступна. ПК не поддерживает аппаратное ускорение, т.к. драйвер устройства установлен неправильно или вовсе не рассчитан на работу этой функции.

Видео: «Как включить и отключить аппаратное ускорение?»

Что делать, если не работает аппаратное ускорение?

Правильная работа аппаратного ускорения зависит от установки драйвера устройства в операционной системе. Диск с драйверами обычно идёт в комплекте с компьютером. Если такой отсутствует, то драйвера можно найти и скачать на официальном сайте.

Ещё одной причиной неправильной работы или отсутствия функции аппаратного ускорения может быть устаревшая версия Direct X (или его отсутствие). Скачать пакет Direct X возможно на просторах глобальной сети.

Корректная работа аппаратного ускорения зависит от наличия обновлённого пакета Direct X

Корректная работа аппаратного ускорения зависит от наличия обновлённого пакета Direct X

Разгон операционной системы

Очистка жёсткого диска

Самый распространённый способ оптимизации операционной системы - это очистка от лишних и даже вредных файлов. Это могут быть копии, отчёты активных программ, временные файлы, кэш программ-обозревателей и т.д. Пути, по которым можно вручную удалить временные файлы:

- C:\Users\Имя пользователя\AppData\Local\Temp;

- C:\Windows\Temp;

- C:\Users\Все пользователи/TEMP;

- C:\Users\Default\AppData\Local\Temp;

- недавние документы: C:\Users\имя пользователя\AppData\Roaming\Microsoft\Windows\Recent\;

- временные файлы интернета: C:\Users\имя пользователя\AppData\Local\Microsoft\Windows\Temporary Internet Files\;

Для очистки диска от временных и неиспользуемых файлов также применяется стандартный инструмент «Очистка диска» от ОС Windows. Нажимаем «Пуск» ->»Все программы» -> «Стандартные» -> «Служебные». Затем запускаем программу. Выбираем нужный нам диск, снимаем/ставим указатели напротив именно тех категорий файлов, которые необходимо очистить (удалить), приступаем к его очистке.

Дефрагментация жёсткого диска

Ещё один удобный способ оптимизации системы - это дефрагментация. Эта процедура даёт возможность увеличения скорости доступа к файлам и, как следствие, увеличения скорости работы системы. Все зависит в итоге от уровня фрагментированности диска: при высоком её значении быстродействие повышается ощутимо.

Программа для дефрагментации находится: пуск->все программы->стандартные ->служебные. И далее выбираем «дефрагментация диска». Указываем нужный диск для дефрагментации. К тому же, программа проводит анализ диска и может подсказать пользователю, нужна ли дефрагментация в данный момент. А по желанию пользователь задаёт расписание, по которому будет производиться эта процедура.

Дефрагментация жёсткого диска - один из видов оптимизации

Дефрагментация жёсткого диска - один из видов оптимизации

Настройка визуальных эффектов

В интерфейс системы включено множество визуальных эффектов, которые служат для создания презентабельности, уникальности и, в каком-то смысле, стиля внешнему виду системы. Однако на производительность такие эффекты оказывают негативное влияние, т.к. занимают большой объем оперативной памяти. И многие эффекты малозаметны, поэтому совершенно не нужны.

Для того чтобы произвести оптимизацию визуальных эффектов стоит открыть «Проводник», затем выбрать пункт «Дополнительные параметры системы». Во вкладке «Быстродействие» выбираем «Параметры». Теперь пользователю открыто меню, где он может управлять работой визуальных эффектов.

Настройка визуальных эффектов производится в Панели Управления

Настройка визуальных эффектов производится в Панели Управления

Автозагрузка

На производительность компьютера при запуске очень часто влияют программы в автозагрузке. Для чистки автозагрузки не понадобятся специальные программы и средства. Сделать это можно с помощью средств операционной системы. В командной строке (вызов командной строки происходит при нажатии клавиш WIN+R) вводим команду MSCONFIG. Так, мы запустим конфигурацию системы. Переходим в пункт «Автозагрузка». В появившемся списке программ вы сможете наблюдать программы, которые относятся к быстрому запуску дефрагментаторов, плееров и т.д. Но разобраться в них не так просто, но интуитивное отключение какой-либо программы из этого списка не повлечёт значительных последствий.

Если на ПК установлены такие операционные системы , как Windows 7,8 и далее, то работа по чистке автозагрузки упрощается. Разработчики вынесли пункт «Автозагрузка» отдельно в Диспетчере Задач. Диспетчер задач открывается комбинацией клавиш Ctrl+Alt+Delete. В поле Диспетчера задач видно, какие процессы запущены прямо сейчас, название и состояния программ вместе с их влиянием на производительность центрального процессора и жёсткого диска. Здесь же можно отключить автозагрузку.

Пошагово последовательность действий при чистке через реестр выглядит так:

- откройте редактор реестра;

- откройте дерево реестра и при этом перейдите по ссылке HKEY_LOCAL_MACHINE\Software\Microsoft\Windows\CurrentVersion;

- обратите внимание на два раздела: «Run Once» и «Run» (в первом подпункте указываются программы, которые следует запустить всего один раз, а во втором - программы для автозапуска);

- внимательно отследить пути запуска, названия и ключи, которые имеются внутри некоторых программ;

- удалить лишние программы;

- то же самое стоит повторить с веткой реестра HKEY_CURRENT_USER;

Внимание стоит обратить и на то, что при отключении какой-либо программы в автозагрузке (в поиске вредоносного рекламного вируса) вполне реально отключить антивирус. Это подвергнет систему ещё большему риску.

Оптимизацию системы очень удобно производить с помощью чистки реестра

Оптимизацию системы очень удобно производить с помощью чистки реестра

Добавление памяти

Оперативная память характеризуется очень важным параметром - объёмом. От объема зависит количество одновременно выполняемых задач. Соответственно, чем больше объем оперативной памяти (в Мегабайтах и далее), тем выше производительность и быстрота работы компьютера.

Добавить оперативную память возможно и аппаратно, то есть в прямом смысле увеличить количество плат памяти в системном блоке компьютера. Оперативку можно подключить и дополнительно, добавив слот под плату либо удобный (иногда самодельный) вывод к контактам над материнской платой. Все эти действия призваны увеличить работоспособность компьютера, а значит, служат ещё одним способом оптимизации операционной системы.

Проверка на вирусы

Наличие рабочей и обновлённой антивирусной программы - гарант избавления от множества проблем и ошибок работы системы. Понижение производительности - один из признаков активности вредоносных программ, которые заполняют собой свободную оперативку. Для того чтобы разгрузить систему, избавить компьютер от ненужных файлов-шпионов и вредоносных ПО, следует своевременно обновлять вирусные базы и следить за состоянием лицензии антивируса. Производить сканирование системы лучше всего по одному и тому же графику: не реже двух-трёх раз в неделю (а при активной работе в интернете и с чужими носителями - четырёх).

Настройка BIOS для ускорения компьютера

Оптимизацию процесса работы системы можно произвести, настроив некоторые параметры в BIOS. Делать это нужно осторожно, чтобы не поспособствовать каким-либо программным ошибкам.

При настройке согласованности работы с процессором необходимо включить следующие параметры:

- CPU Level 1 Cache;

- CPU Level 2 Cache;

- CPU Level 2 Cache ECC Check;

- Boot Up System Speed;

- Cache Timing Control;

Все эти параметры определяют уровень работоспособности системы, скорости работы процессора и обработки информации, стабильность работы процессора.

Также, можно регулировать работу оперативной памяти с помощью параметров:

- DRAM Frequency;

- SDRAM Cycle Length;

- RAS-to-CAS Delay;

- SDRAM RAS Precharge Time;

- FSB/SDRAM/PCI Freq;

- Memory Hole At 15–16M;

- Optimization Method;

В этих параметрах заключается изменение скорости перезаряда ячеек памяти, общая скорость обмена данными с оперативной памятью, частота шин, число тактов, и прочее.

Стоит обратить внимание, что внесение изменений в настройки BIOS может сказаться негативно на работе системы.

Технология ReadyBoost

Технология ReadyBoost присутствует в ОС Windows 7 как связующее звено между оперативной памятью и файлом подкачки. Она используется в работе флеш накопителей (порт USB 2.0) для разгона скорости передачи/обмена данных между устройством и флеш-картой.

Производительность системы тем выше, чем быстрее работает флеш-накопитель

Производительность системы тем выше, чем быстрее работает флеш-накопитель

Для того, чтобы привести технологию в действие вставляем флеш-накопитель в компьютер, дожидаемся автозапуска. В меню автозапуска выбираем пункт «Ускорить работу системы, используя Windows Ready Boost». Если автозапуск по каким-либо причинам не произошёл, то активируем его вручную. Сделать это можно через свойства накопителя в меню «Мой компьютер». Выбираем из списка «Открыть автозапуск».

Для отключения технологии необходимо перейти в меню свойств накопителя, на вкладке ReadyBoost выбрать «Не использовать это устройство».

Программы для ускорения работы компьютера

Программа представляет собой пакет базовых опций по отладке, ремонту, восстановлению и просто мониторингу системы на предмет каких-либо неисправностей. Представлена в двух версиях: платной и бесплатной. Как правило, бесплатная версия не всегда работает корректно, тем более она не включает все компоненты защиты системы, представленные IObit. Обновление бесплатной версии слетает на многих компьютерах, либо не производится совсем. Однако программа по функциональности и форме исполнения в интерфейсе резко отличается от всех остальных в лучшую сторону. Поэтому, если пользователь всерьёз заинтересован в повышении производительности, стоит использовать именно Advanced SystemCare.

Интерфейс

Интерфейс

Ccleaner - простая и предельно действенная программа по очистке и оптимизации системы. Одна из самых лучших программ по надёжности и широте профиля использования. Отличается множеством преимуществ: быстрота запуска/работы, качественный поиск и удаление временных и ненужных системных файлов, как и исправление ошибок реестра довольно результативно. Существует также в платном и бесплатном исполнении. Однако в бесплатной версии потери в функциональности минимальные.

Интерфейс

Интерфейс

Easy Cleaner

Бесплатная программа для стабильной работы системы. Основной её инструмент - чистка реестра Windows . Но, помимо этого, программа выполняет широкий спектр задач по оптимизации. На практике Easy Cleaner - неплохой инструмент, который был бы полезен каждому пользователю ПК. Вот только не всегда программа работает корректно. Часто происходят сбои при удалении файлов (после их поиска), повисание программы в процессе её работы. На форумах встречаются негативные отзывы и низкие оценки программы.

Red Button

Изначально программа задумывалась как лёгкое незамысловатое решение по оптимизации системы для пользователей - дилетантов. Всё, что нужно - это нажать на большую красную кнопку. Результат получится сам собой. В этом заключается простота программы.

Последние версии Red Button с недавнего времени платные. Также существуют аналоги программы, цены на которые сейчас максимально подняты. По отзывам программа не отличается высокой надёжностью, и нет ничего необычного в её работе. Red Button - самый простой обывательский инструмент оптимизации и очистки системы.

Чтобы не сталкиваться с проблемами слабой производительности, нужно следить за тщательной оптимизацией системы. И делать это стоит независимо от того, каким родом деятельности вы занимаетесь на ПК. Правила чистки и предотвращения захламления оперативной памяти и жёсткого диска обеспечат правильную и результативную работу вашего компьютера.

Скорость и производительность работы компьютера определяется множеством факторов. Невозможно добиться ощутимого повышения производительности за счёт улучшения характеристик какого-либо одного устройства, например, за счёт повышения тактовой частоты процессора. Только тщательно подобрав и сбалансировав все компоненты компьютера можно добиться существенного повышения производительности работы компьютера.

Следует помнить, что компьютер не может работать быстрее, чем самое медленное из устройств, задействованных для выполнения этой задачи.

Тактовая частота процессора

Наиболее важный параметр производительности компьютера - скорость процессора , или, как её называют, тактовая частота , которая влияет на скорость выполнения операций в самом процессоре . Тактовой частотой называют рабочую частоту ядра процессора (т. е. той части, которая выполняет основные вычисления) при максимальной загрузке. Отметим, что другие компоненты компьютера могут работать на частотах, отличных от частоты процессора.

Измеряется тактовая частота в мегагерцах (MHz) и гигагерцах (GHz) . Количество тактов в секунду, выполняемых процессором, не совпадает с количеством операций, выполняемых процессором за секунду, поскольку для реализации многих математических операций требуется несколько тактов. Понятно, что в одинаковых условиях процессор с более высокой тактовой частотой должен работать эффективнее, чем процессор с более низкой тактовой частотой.

С увеличением тактовой частоты процессора увеличивается и число операций, совершаемых компьютером за одну секунду, а следовательно, возрастает и скорость работы компьютера.

Объем оперативной памяти

Важным фактором, влияющим на производительность компьютера, является объем оперативной памяти и её быстродействие (время доступа, измеряется в наносекундах). Тип и объем оперативной памяти оказывает большое влияние на скорость работы компьютера.

Самым быстро работающим устройством в компьютере является процессор . Вторым по скорости работы устройством компьютера является оперативная память, однако, оперативная память значительно уступает процессору по скорости.

Чтобы сравнить скорость работы процессора и оперативной памяти, достаточно привести только один факт: почти половину времени процессор простаивает в. ожидании ответа от оперативной памяти. Поэтому чем меньше время доступа к оперативной памяти (т. е. чем она быстрее), тем меньше постаивает процессор, и тем быстрее работает компьютер.

Чтение и запись информации из оперативной памяти осуществляется значительно быстрее, чем с любого другого устройства для хранения информации, например, с винчестера, поэтому увеличение объёма оперативной памяти и установка более быстрой памяти приводит к увеличению производительности компьютера при работе с приложениями.

Объем жёсткого диска и скорость работы жёсткого диска

На производительность компьютера влияет скорость связи шины жёсткого диска и свободный объем дискового пространства.

Объем жёсткого диска, как правило, влияет на количество программ, которые вы можете установить на компьютер, и на количество хранимых данных. Ёмкость накопителей для жёстких дисков измеряется, как правило, десятками и сотнями гигабайт.

Жёсткий диск работает медленнее, чем оперативная память . Так как скорость обмена данными для жёстких дисков Ultra DMA 100 не превышает 100 мегабайт в секунду (133 Мбайт/сек для Ultra DMA 133). Ещё медленнее происходит обмен данными в DVD и CD-приводах.

Важными характеристиками винчестера, влияющими на Скорость работы компьютера, являются:

- Скорость вращения шпинделя;

- Среднее время поиска данных;

- Максимальная скорость передачи данных.

Размер свободного места на жёстком диске

При нехватке места в оперативной памяти компьютера Windows и многие прикладные программы вынуждены размещать часть данных, необходимых для текущей работы, на жёстком диске, создавая так называемые временные файлы (swap files) или файлы подкачки .

Поэтому важно, чтобы на диске было достаточно свободного места для записи временных файлов. При недостатке свободного места на диске многие приложения просто не могут корректно работать или их скорость работы значительно падает.

После завершения работы приложения все временные файлы, как правило, автоматически удаляются с диска, освобождая место на винчестере. Если размер оперативной памяти достаточен для работы (не менее нескольких Гб), то размер файла подкачки для персонального компьютера не так существенно влияет на быстродействие компьютера и может быть установлен минимальным.

Дефрагментация файлов

Операции удаления и изменения файлов на диске приводят к фрагментации файлов, выражающейся в том, что файл занимает не соседние области на диске, а разбивается на несколько частей, хранящихся в разных областях диска. Фрагментация файлов приводит к дополнительным затратам на поиск всех частей открываемого файла, что замедляет доступ к диску и уменьшает (как правило, не существенно) общее быстродействие диска.

Например, для выполнения дефрагментации в операционной системе Windows 7 щёлкните по кнопке Пуск и в раскрывшемся главном меню выберите последовательно команды Все программы, Стандартные, Служебные, Дефрагментация диска .

Количество одновременно работающих приложений

Windows - многозадачная операционная система , которая позволяет одновременно работать сразу с несколькими приложениями. Но чем больше приложений одновременно работают, тем сильнее возрастает нагрузка на процессор, оперативную память, жёсткий диск, и тем самым замедляется скорость работы всего компьютера, всех приложений.

Поэтому те приложения, которые не используются в данный момент, лучше закрыть, освобождая ресурсы компьютера для оставшихся приложений.

Системы хранения данных для подавляющего большинства веб-проектов (и не только) играют ключевую роль. Ведь зачастую задача сводится не только к хранению определенного типа контента, но и к обеспечению его отдачи посетителям, а также обработки, что накладывает определенные требования к производительности.

В то время, как при производстве накопителей используется множество других метрик, чтоб описать и гарантировать должную производительность, на рынке систем хранения и дисковых накопителей, принято использовать IOPS, как сравнительную метрику, с целью «удобства» сравнения. Однако производительность систем хранения, измеряемая в IOPS (Input Output Operations per Second), операциях ввода / вывода (записи / чтения), подвержена влиянию большого множества факторов.

В этой статье я хотел бы рассмотреть эти факторы, чтобы сделать меру производительности, выраженную в IOPS, более понятной.

Начнем с того, что IOPS вовсе не IOPS и даже совсем не IOPS, так как существует множество переменных, которые определяют сколько IOPS мы получим в одних и других случаях. Также следует принять во внимание, что системы хранения используют функции чтения и записи и обеспечивают различное количество IOPS для этих функций в зависимости от архитектуры и типа приложения, в особенности в случаях, когда операции ввода / вывода происходят в одно и тоже время. Различные рабочие нагрузки предъявляют различные требования к операциям ввода / вывода (I/O). Таким образом, системы хранения, которые на первый взгляд должны были бы обеспечивать должную производительность, в действительности могут не справится с поставленной задачей.

Основы производительности накопителей

Для того, чтоб приобрести полноценное понимание в вопросе, начнем с основ. IOPS, пропускная способность (MB/s или MiB/s) и время отклика в миллисекундах (мс) являются общепринятыми единицами измерения производительности накопителей и массивов из них.IOPS обычно рассматривают в ключе измерения способности устройства хранения производить чтение / запись блоками размером 4-8КБ в случайном порядке. Что типично для задач онлайн-обработки транзакций, баз данных и для запуска различных приложений.

Понятие пропускной способности накопителя обычно же применимо при чтении / записи крупного файла, к примеру, блоками 64КБ и более, последовательно (в 1 поток, 1 файл).

Время отклика - время, которое необходимо накопителю для того, чтоб начать производить операцию записи / чтения.

Преобразование между IOPS и пропускной способностью может быть выполнено следующим образом:

IOPS = пропускная способность / размер блока;

Пропускная способность = IOPS * размер блока,

Где размер блока - количество информации, переданное на протяжении одной операции ввода / вывода (I/O). Таким образом, зная такую характеристику жесткого диска (HDD SATA), как пропускную способность - мы с легкостью можем вычислить количество IOPS.

К примеру, возьмем стандартный размер блока - 4КБ и стандартную пропускную способность, заявленную производителем для последовательной записи или чтения (I/O) - 121 Мбайт / с. IOPS = 121 МБ / 4 КБ, в результате чего получим значение порядка 30 000 IOPS для нашего жесткого диска SATA . Если же размер блока увеличить и сделать равным 8 КБ, значение будет порядка 15 000 IOPS, то есть снизится практически пропорционально увеличению размера блока. Однако нужно четко понимать, что тут мы рассматривали IOPS в ключе последовательной записи или чтения.

Все меняется драматическим образом для традиционных жестких SATA дисков, если чтение и запись будут случайными. Тут начинает играть роль задержка (latency), которая очень критична в случае жестких дисков HDDs (Hard Disk Drives) SATA / SAS, а порой даже и в случае твердотельных накопителей SSD (Solid State Drive). Хотя последние зачастую обеспечивают производительность на порядки лучшую, чем у «вращающихся» накопителей, за счет отсутствия движущихся элементов, но все же могут возникать ощутимые задержки при записи, в виду особенностей технологии, и, как следствие, при использовании их в массивах. Глубокоуважаемый amarao провел довольно полезное исследование по использованию твердотельных накопителей в массивах, как выяснилось, производительность будет зависеть от latency самого медленного из дисков. Более подробно с результатами Вы можете ознакомиться в его статье: SSD + raid0 - не всё так просто .

Но вернемся к производительности отдельно взятых накопителей. Рассмотрим случай с «вращающимися» накопителями. Время, требуемое для выполнения одной случайной операции ввода / вывода будет определятся такими составляющими:

T(I/O) = T(A)+T(L)+T(R/W),

Где T(A) - время доступа (access time или seek time), также известное, как время поиска, то есть время, требуемое для того, чтоб считывающая головка, была помещена на дорожку с нужным нам блоком информации. Зачастую в спецификации диска производителем указываются 3 параметра:

Время, требуемое, чтоб переместиться с самой дальней дорожке к самой ближней;

- время, требуемое для перемещения между смежными дорожками;

- среднее время доступа.

Таким образом мы приходим к волшебному выводу, что показатель T(A) может быть улучшен, если мы размещаем наши данные на как можно более близких дорожках, а все данные располагаются как можно дальше от центра пластины (требуется меньше времени для перемещения блока магнитных головок, а на внешних дорожках данных больше, так как больше длина дорожки и она вращается быстрее, нежели внутренняя). Теперь становится понятно почему дефрагментация может быть так полезна. Особенно с условием размещения данных на внешних дорожках в первую очередь.

T(L) - задержка, вызванная вращением диска, то есть время, требуемое для того, чтоб считать или записать конкретный сектор на нашей дорожке. Легко понять, что оно будет лежать в пределах от 0 до 1/RPS, где RPS - количество оборотов в секунду. К примеру при характеристике диска в 7200 RPM (оборотов в минуту) мы получим 7200/60 = 120 оборотов в секунду. То есть один оборот происходит за (1/120) * 1000 (количество миллисекунд в секунде) = 8,33 мс. Средняя же задержка в этом случае, будет равна половине времени, затрачиваемому на один оборот - 8,33/2 = 4,16 мс.

T(R/W) - время чтения или записи сектора, которое определяется размером выбранного при форматировании блока (от 512 байт и до… нескольких мегабайт, в случае с более емкими накопителями - от 4 килобайт, стандартный размер кластера) и пропускной способностью, которая указана в характеристиках накопителя.

Среднюю задержку вращения, которая приблизительно равна времени, затраченному на половину оборота, зная скорость вращения 7200, 10 000 или 15 000 RPM, легко определить. И выше мы уже показали как.

Остальные же параметры (среднее время поиска чтения и записи) определить сложнее, они определяются уже в результате тестов и указываются производителем.

Для расчета количества случайных IOPs жесткого диска возможно применить следующую формулу, при условии когда количество одновременных операций чтения и записи одинаково (50%/50%):

1/(((среднее время поиска чтения + среднее время поиска записи) / 2) / 1000) + (средняя задержка вращения / 1000)).

Многие интересуются, почему именно такое происхождение формулы? IOPS - количество операций ввода или вывода в секунду. Именно потому мы делим в числителе 1 секунду (1000 миллисекунд) на время с учетом всех задержек в знаменателе (выраженное также в секундах или миллисекундах), требуемое для осуществления одной операции ввода или вывода.

То есть формула может быть записана и таким образом:

1000 (мс) / ((среднее время поиска чтения (мс) + среднее время поиска записи (мс)) /2) + средняя задержка вращения (мс))

Для накопителей с различным количеством RPM (вращений в минуту), мы получим следующие значения:

Для 7200 RPM накопителя IOPS = 1/(((8,5+9,5)/2)/1000) + (4,16/1000)) = 1/((9/1000) +

(4,16/1000)) = 1000/13,16 = 75,98;

Для 10K RPM SAS накопителя IOPS = 1/(((3,8+4,4)/2)/1000) + (2,98/1000)) =

1/((4,10/1000) + (2,98/1000)) = 1000/7,08 = 141,24;

Для 15K RPM SAS накопителя IOPS = 1/(((3,48+3,9)/2)/1000) + (2,00/1000)) =

1/((3,65/1000) + (2/1000)) = 1000/5,65 = 176,99.

Таким образом мы видим драматические изменения, когда с десятков тысяч IOPS при последовательном чтении или записи, производительность падает до нескольких десятков IOPS.

И уже, при стандартном размере сектора в 4КБ, и наличию столь малого числа IOPS, мы получим значение пропускной способности отнюдь не в сотню мегабайт, а менее, чем в мегабайт.

Эти примеры также иллюстрируют причину незначительных изменений в номинальных дисковых IOPS от разных производителей для дисков с одним и тем же показателем RPM.

Теперь становится понятным, почему данные производительности, лежат в довольно широких диапазонах:

7200 RPM (Rotate per Minute) HDD SATA - 50-75 IOPS;

10K RPM HDD SAS - 110-140 IOPS;

15K RPM HDD SAS - 150-200 IOPS;

SSD (Solid State Drive) - десятки тысяч IOPS на чтение, сотни и тысячи на запись.

Однако номинальный дисковый IOPS остается все же далеко неточными, так как не учитывает различий в характере нагрузок в отдельно взятых случаях, что очень важно понимать.

Также, для лучшего понимания темы, рекомендую ознакомиться еще с одной полезной статьей от amarao : Как правильно мерять производительность диска , благодаря которой становиться также понятным, что latency вполне не фиксирована и также зависит от нагрузки и ее характера.

Единственное, хотелось бы добавить:

При расчете производительности жесткого диска можно пренебречь снижением количества IOPS при увеличении размера блока, почему?

Мы уже поняли, что для «вращающихся» накопителей, время, требуемое для случайного чтения или записи, складывается из следующих компонент:T(I/O) = T(A)+T(L)+T(R/W).

И далее даже рассчитали производительность при случайном чтении и записи в IOPS. Вот только параметром T(R/W) мы там по сути пренебрегли, и это не случайно. Мы знаем, что допустим, последовательное чтение может быть обеспечено на скорости в 120 мегабайт в секунду. Становится понятным, что блок в 4КБ, будет считан за примерно 0,03 мс, время на два порядка меньшее, нежели время остальных задержек (8 мс + 4 мс).

Таким образом, если при размере блока в 4КБ мы имеем 76 IOPS (основная задержка была вызвана вращением накопителя и временем позиционирования головки, а не самим процессом чтения или записи), то при размере блока в 64КБ, падение IOPS будет не в 16 раз, как при последовательном чтении, а лишь на несколько IOPS . Так как время, затрачиваемое на непосредственно чтение или запись, возрастет на 0,45 мс, что составляет лишь порядка 4% от общего времени задержки.

В результате мы получим 76-4% = 72,96 IOPS, что согласитесь, совсем не критично при расчетах, так как падение IOPS не в 16 раз, а лишь на несколько процентов! И при расчетах производительности систем куда важнее не забыть учесть другие важные параметры.

Волшебный вывод: при расчете производительности систем хранения, основанных на жестких дисках, следует подбирать оптимальный размер блока (кластера), для обеспечения нужной нам максимальной пропускной способности в зависимости от типа данных и используемых приложений, причем падением IOPS при увеличении размера блока с 4КБ до 64КБ или даже 128КБ можно пренебречь, либо учитывать, как 4 и 7% соответсвенно, если в поставленной задаче они будут играть важную роль.

Также становится понятным, почему не всегда есть смысл использовать очень большие блоки. Скажем, при видеостриминге, двухмегабайтный размер блока может оказаться далеко не самым оптимальным вариантом. Так как падение количества IOPS будет более, чем в 2 раза. Помимо прочего добавятся другие деградационные процессы в массивах, связанные с многопоточностью и вычислительной нагрузкой при распределении данных по массиву.

Оптимальный размер блока (кластера)

Оптимальный размер блока нужно учитывать в зависимости от характера нагрузки и типа используемых приложений. Если идет работа с данными небольшого размера, к примеру с базами данных - следует выбрать стандартные 4 КБ, если же речь идет о стриминге видеофайлов - размер кластера лучше выбирать от 64 КБ и более.Следует помнить, что размер блока не столь критичен для SSD, сколько для стандартных HDD, так как позволяет обеспечить нужную пропускную способность в виду небольшого количества случайных IOPS, количество которых снижается незначительно при увеличении размера блока, в отличии от SSD, где наблюдается практически пропорциональная зависимость.

Почему стандарт 4 КБ?

Для многих накопителей, в особенности твердотельных, значения производительности, к примеру записи, начиная с 4 КБ, становятся оптимальными, это видно из графика:В то время, как на чтение, скорость также довольно существенна и более менее сносна начиная с 4 КБ:

Именно по этой причине 4 КБ размер блока очень часто применяют за стандартный, так как при меньшем размере идут большие потери производительности, а при увеличении размера блока, в случае работы с небольшими данными, данные будут распределены менее эффективно, занимать весь размер блока и квота накопителя будет использоваться не эффективно.

Уровень RAID

Если Ваша система хранения представляет собой массив накопителей объединенных в RAID определенного уровня, то производительность системы будет зависеть в значительной степени от того, какой именно уровень RAID был применен и какой процент от общего числа операций приходится на операции записи, ведь именно запись является причиной снижения производительности в большинстве случаев.Так, при RAID0, на каждую операцию ввода будет расходоваться лишь 1 IOPS, ведь данные будут распределены по всем накопителям без дублирования. В случае же зеркала (RAID1, RAID10), каждая операция записи будет потреблять уже 2 IOPS, так как информация должна быть записана на 2 накопителя.

В более высоких уровнях RAID потери еще существеннее, к примеру в RAID5 штрафной коэффициент будет уже 4, что связано с тем, каким образом данные распределяются по дисках.

RAID5 используется вместо RAID4 в большинстве случаев, так как распределяет четность (контрольные суммы) по всем дискам. В массиве RAID4 один из дисков ответственен за всю четность, в то время как данные распространены более чем на 3 диска. Именно потому мы применяем штрафной коэффициент 4 в массиве RAID5, так как мы читаем данные, читаем четность, затем пишем данные и пишем четность.

В массиве RAID6 все аналогично, за исключением того, что мы вместо вычисления четности единожды, делаем это дважды и таким образом имеем 3 операции чтения и 3 записи, что дает нам уже штрафной коэффициент 6.

Казалось бы, что в таком массиве, как RAID-DP все будет аналогично, так как это по сути модифицированный массив RAID6. Но не тут то было… Хитрость заключается в том, что применяется отдельная файловая система WAFL (Write Anywhere File Layout), где все операции записи последовательны и производятся на свободное место. WAFL в основном напишет новые данные в новое местоположение на диске и затем переместит указатели на новые данные, устраняя таким образом операции чтения, которые должны иметь место. Кроме того идет запись журнала в NVRAM, который отслеживает транзакции записи, инициирует запись и может восстановить их при необходимости. Идет запись в буфер в начале, а затем они уже «сливаются» на диск, что ускоряет процесс. Вероятно эксперты в NetApp могут просветить нас более подробно в комментариях, за счет чего достигается экономия, я пока что еще не до конца разобрался в этом вопросе, но запомнил, что штрафной коэффициент RAID будет всего лишь 2, а не 6. «Хитрость» весьма существенна.

При больших массивах RAID-DP, которые состоят из десятков дисков, существует понятие уменьшения «штрафа четности», который возникает при записи четности. Так при росте массива RAID-DP, требуется меньшее количество дисков, выделяемых под четность, что приведет к снижению потерь, связанных с записями четностей. Однако в небольших массивах, либо с целью повышения консерватизма, мы можем пренебречь этим явлением.

Теперь, зная о потерях IOPS в результате применения того либо другого уровня RAID, мы можем рассчитать производительность массива. Однако, пожалуйста, примите к сведению, что другие факторы, такие как пропускная способность интерфейса, неоптимальное распределение прерываний по ядрах процессора и т.п., пропускная способность RAID-контроллера, превышение допустимой глубины очереди - могут оказывать негативное влияние.

В случае пренебрежения этими факторами, формула будет следующей:

Функциональные IOPS = (Исходные IOPS * % операций записи / штрафной коэффициент RAID) + (Исходные IOPS * % чтения), где Исходные IOPS = усредненный IOPS накопителей * количество накопителей.

Рассчитаем для примера производительность массива RAID10 из 12 дисков HDD SATA, если известно, что одновременно происходит 10% операций записи и 90% операций чтения. Допустим, что диск обеспечивает 75 случайных IOPS, при размере блока 4КБ.

Исходные IOPS = 75*12 = 900;

Функциональные IOPS = (900*0,1/2) + (900*0,9) = 855.

Таким образом видим, что при малой интенсивности записи, что в основном наблюдается в системах, рассчитанных на отдачу контента, влияние штрафного коэффициента RAID минимально.

Зависимость от приложений

Производительность нашего решения очень сильно может зависеть от приложений, которые будут исполнятся впоследствии. Так это может быть обработка транзакций - «структурированных» данных, которые организованы, последовательны и предсказуемы. Зачастую в этих процессах можно применить принцип пакетной обработки, распределив эти процессы во времени так, когда нагрузка минимальна, тем самым оптимизировав потребление IOPS. Однако в последнее время появляется все больше и больше медийных проектов, где данные «не структурированы» и требуют совсем иных принципов их обработки.По этой причине подсчет необходимой производительности решения для конкретного проекта может стать весьма сложной задачей. Некоторые из производителей сторедж-хранилищ и экспертов утверждают, что IOPS не имеют значения, так как клиенты в подавляющем большинстве используют до 30-40 тысяч IOPS, в то время, как современные системы хранения обеспечивают сотни тысяч и даже миллионы IOPS. То есть современные хранилища удовлетворяют нужды 99% клиентов. Тем не менее это утверждение может быть справедливо далеко не всегда, лишь для бизнес-сегмента, который размещает хранилища у себя, локально, но не для проектов, размещаемых в дата-центрах, которые зачастую, даже при использовании готовых решений хранения, должны обеспечивать довольно высокую производительность и отказоустойчивость.